2024版本才用上新UI

- 禁止隐藏工具窗口按钮:Settings → Advanced Settings → Always show tool window header icons(让自己显得更简洁实际上是脱裤子放屁降低效率的行为)

97 条说说

2024版本才用上新UI

打破移动技术垄断,实现自主可控墙中墙

迈从gx87 v2这个400不到一点的2kg重的铝合金键盘有点香。一段时间没买键盘又更卷了,以前这个配置起码要八百。但是下单了好多次又秒退了。配列是我喜欢的87,但是加了一个f13按键我很讨厌,妨碍使用频率还挺高的f11和f12。方向键上面的rgb灯条从v1的单纯条带变成牌子logo也不好看。

还有国产卷王键盘一贯的拉胯主控芯片,关灯续航只有一个月,而且还不让用快充头。

现在用的键盘芯片是真的强,半年的续航而且感觉锂电池自放电都浪费了不少。更何况还支持卷王们最怕的快充,虽然只有10w

红米ax6000二手好坚挺啊,现在居然还值370左右。好像我是22年左右四百多买的。可能是cpu比较强大,能干两百的arm软路由,又方便刷机吧。

看了一圈wifi7路由器,发现都不能刷机的样子。最后买了发哥filogic860芯片的tplink 7dr7230,花费320元。

红米的filogic830(mt7986)确实挺好,wifi6刷机之王,性能不赖,现在还有磊科n60 pro带双2.5g口和usb口并且只要300元(所以就更搞不懂还要买二手红米的大怨种咋想的),但是外观奇丑无比还是算了。毕竟买来我就当个ap,不能刷机也无所谓了。

7dr7230带十几个2.4g设备极低负载功耗5w,ax6000根据评测是7w。6nm制程必须得比12nm省电点。

换了漏油器之后2.4g信号好了很多,原来米家一直显示信号弱的几个智能插座终于好了。

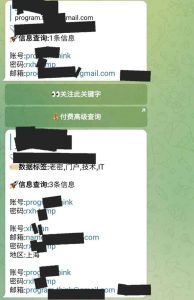

编程随想被开盒的路径:

Gmail邮箱地址(他的博客上公开的) ➡ 密码rxh-temp(电报等地方查社工库)

博客文章配图暴露用户名➡RUAN\rxh(虽然马上就编辑掉了但是archive.org还有,更不用说随时都在视奸的那批)

xhruan(社工库密码再搜索) ➡ CSDN博客 ➡ CSDN密码找回 ➡ ru***@netstd.com➡ 上海金诺网络安全技术公司➡ 搜索:金诺网安+阮 ➡阮晓寰

汇总自:

https://pincong.rocks/article/56252

https://pincong.rocks/article/62481

https://2047.one/t/20743

https://2047.one/t/20785

这个MCP官方的Java SDK调用ServerResponse.sse()提供的SSE服务永远不会关闭socket,客户端关闭TCP连接后一直TIME_WAIT,如果是linux系统fd永远释放不了,直到爆掉上限无法建立网络连接。lsof显示的僵尸fd如下:

java 22507 root 73u sock 0,7 0t0 3469578 protocol: TCPv6

(一样的代码,windows系统居然会在某种条件下一段时间后自动关闭,未深究)

这个里面调用的是AsyncServerResponse,官方文档如下:

The Servlet API does not provide any notification when a remote client goes away. Therefore, while streaming to the response, whether through SseEmitter or reactive types, it is important to send data periodically, since the write fails if the client has disconnected. The send could take the form of an empty (comment-only) SSE event or any other data that the other side would have to interpret as a heartbeat and ignore.

这么大的问题居然一个多月都没修,说明就没有多少人高强度使用(Java)MCP……

另外,靠谱的客户端断连检测只尝试读取socket是不行的,还是要靠心跳机制。可能官方怕MCP客户端不支持ping所以没实现

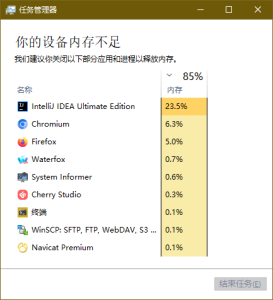

虚拟内存满了原来是这样的,以前从来没看过任务管理器这个界面。清除一点内存然后重新打开,大小还是按这个特殊界面缩小过的,要手动扩大到原来的大小。这里的大标题也不知道为什么要用衬线体,果不其然一股印度咖喱味

一直看到IDE提示过时deprecated,但是很多个版本了还没有移除,探究了一下发现开发团队说不会移除了,只是会一直警告而已。https://github.com/angular/angular/issues/25160

一直都用这个功能自定义第三方框架内部的样式非常好用,只要限定好选择器就不会影响其他组件。比如

.some-class-in-component ::ng-deep .internal-class {}

当然不排除技术垃圾的会直接开头就::ng-deep起手,但是工具不应该给他们擦屁股。